A 2010-es évek végén kapott nagyobb figyelmet szoftverfejlesztés és a rendszerüzemeltetés területén a monitoring továbbfejlesztett módja, az obszervabilitás. Az események, logok és egyéb mérőszámok nyers kimenetének rendszerbe szervezésével ugyanis a szoftvermérnökök valós idejű képet szerezhetnek rendszerek teljesítményéről, ezáltal gyorsan felmérhetik a gyenge pontokat és hatékony támogatást kapnak az optimalizáláshoz.

A hagyományos monitoring a logok, a metrikák és a szolgáltatások end-to-end követésére épül, és előre konfigurált dashboardokon jelzi a várható teljesítményproblémákat. Ennek azonban van egy komoly korlátja: azon a feltételezésen alapul ugyanis, hogy előre meg lehet jósolni, milyen típusú problémák következnek be.

Kezdetektől a mikroszervizekig

Az irányításelméletből származó fogalom eredetileg azt jelentette, hogy a rendszer kimenetei alapján rekonstruálhatóvá válik a belső állapota. A obszervabilitás elődje az egyszerű monitorozás, amely során rendszergazdák és fejlesztők alapvető metrikákat és logokat gyűjtöttek az alkalmazások és az infrastruktúra állapotának nyomon követésére olyan eszközökkel, mint például a Nagios vagy a Zabbix. Mivel azonban ezek előre definiált szabályokra és küszöbértékekre épülnek, képesek a váratlan hibák és anomáliák detektálására, de nem elég rugalmasak.

A felhőalapú infrastruktúra és a konténerek, mint a Docker vagy a Kubernetes térnyerésével a rendszerek egyre dinamikusabbak és összetettebbek lettek. Ez fejlettebb megfigyelési módszer kifejlődéséhez vezetett, amely már nem csak jelzi a hibát, hanem bekövetkeztének okát is segít beazonosítani. Az olyan új, nyílt forrású eszközökkel, mint a Prometheus, a Grafana vagy a Logstash, lehetővé vált az idősoros metrikák gyűjtése, a riasztások fejlesztése. Könnyebben és látványosabban megjeleníthetővé váltak az incidensek a vizualizációs eszközök fejlődésével.

A következő lépcsőt a mikroszervizek és a három pillér létrejötte jelentette. Előbbi elterjedésével az alkalmazások kisebb, önálló komponensekre darabolódnak, amelyeket különböző csapatok fejlesztenek és üzemeltetnek. Ez új obszervabilitási modellhez vezetett, amely három fő komponensre, vagyis pillérre épül. A logok részletes eseményadatokkal szolgálnak az alkalmazásból, a metrikák kvantitatív méréseket – például processzorhasználat, válaszidő, hibaarány – biztosítanak, a nyomkövetés révén pedig lehetővé vált a tranzakciók és folyamatok követése több mikroszervizen keresztül. A három pillér együttes elemzése nagyban segíti az összefüggések megértését és a gyors hibakeresést.

Jellemző eszközeik közé tartozik az OpenTelemetry; a sandbox projekt egyre inkább kvázi iparági standarddá válik az obszervabilitás területén. Szintén kedvelt alkalmazás az ugyancsak nyílt forrású Jaeger, melyet nyomkövetésre alkalmaznak. Az olyan szállítók, mint a Datadog vagy a Honeycomb, gyakorlatilag azonnal használható eszközökkel, vagy akár felhőalapú szolgáltatásokkal képesek segíteni a fejlesztőcsapatok munkáját.

Színre lép a mesterséges intelligencia

Természetesen napjaink hívószava, a mesterséges intelligencia sem hagyta érintetlenül az obszervabilitás területét. Az MI-alapú analitika számos területen fokozza a hatékonyságot; például gépi tanulással a hibák előrejelzésében. Szintén hasznos, befektetett munkát és időt spóroló lehetőség az automatizált hibaazonosítás és diagnosztika vagy az úgynevezett root cause analysis. Az anomáliák felismerésével a hiba bekövetkezése előtt be lehet avatkozni, tehát a legfrissebb obszervabilitási rendszerek már proaktívan és prediktíven működnek.

A mesterséges intelligenciára alapuló megoldásokkal egyre inkább automatizálttá válik a hibaelhárítás, és önjavítóvá válik a rendszer. A obszervabilitást biztosító rendszerek ezáltal gyakorlatilag elengedhetetlen részét képezik az AIOps-nak, vagyis az informatikai üzemeltetés mesterséges intelligenciával való automatizálásának.

IT-üzemeltetés MI alapokon

Az emberi beavatkozások szükségességének csökkentését, a gyorsabb hibakeresést és a várható IT-problémák proaktív előrejelzését együttesen lehetővé tevő megoldások messze távolodtak a klasszikus IT-monitoring eszközöktől. Ezek ugyan rengeteg adatot (logok, események, egyéb mérőszámok) gyűjtenek, elemzésük, feldolgozásuk humán alapokon nehézkes és lassú. Obszervabilitás alkalmazásával automatikussá tehetők az összefüggések felfedése, minimalizálható a „zaj”, és kevesebb, de pontosabb riasztásokat kap a mérnökcsapat.

Ezek ismeretében egyáltalán nem meglepő, hogy az előrejelzések szerint stabil növekedés várható a szegmensben. A Grand View Research felmérése szerint a 2023-as évben 2,7 milliárd dolláros piac éves szinten közel 11 százalékot bővül 2030-ig, a Markets And Markets pedig 11,7 százalékos éves növekedés mellett 4,1 milliárd dolláros piaci kapitalizációt prognosztizál 2028-ra. Az észak-amerikai régió uralja a piacot közel 50 százalékos részesedéssel, amely mellett az európai és az ázsiai szegmens képvisel még jelentős szerepet.

Hasonlóan dinamikus bővülést jósol a szegmensnek tavaly augusztusban kiadott Magic Quadrant for Observability Platforms című jelentésében a Gartner is. Az elemző cég szerint az obszervalitást biztosító termékek piaca 2027-re elérheti a 11,1 milliárd dollárt.

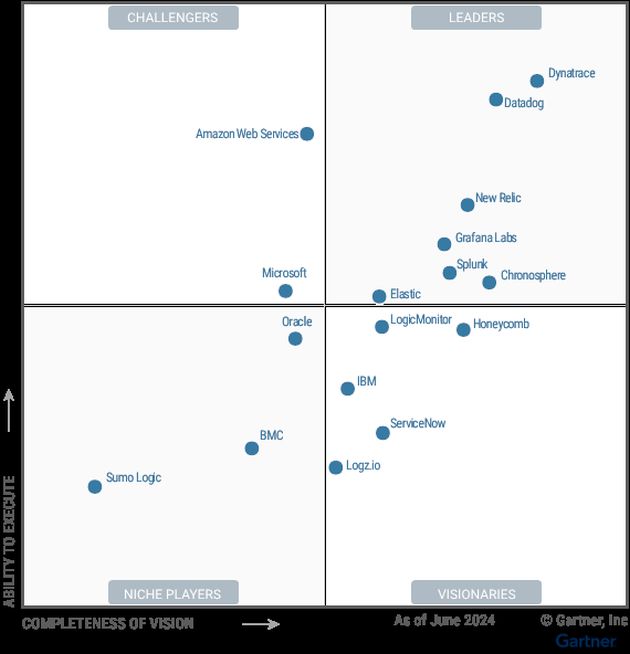

Az obszervalitási eszközök piacának legfontosabb szereplői a Gartner szerint

(Forrás: Gartner)

Bár a tanulmányban csak 17 terméket elemeznek, a piackutató cég már több mint 40 szállító fejlesztéseit követi nyomon. Elemzői szerint a piacon azok a megoldások lesznek a nyerők, melyek jól lekövetik a felügyeleti területek és gyakorlatok konszolidációja iránti ügyféligényt.

Mint a fenti ábrán is látható, a Gartner szerint a szegmensnek a Dynatrace a vezető szereplője (egyébként már hosszú évek óta). Ezt a Magic Quadrant elemzői szerint annak köszönheti, hogy platformként kínál ún. kiterjesztett obszervabilitást: a logok, a metrikák és a tracking adatok mellett bevonja elemzéseibe a metaadatokat, a felhasználói viselkedést, a hálózati topológiát és a network mappinget, sőt akár a kód szintjéig is lemegy. Emellett biztonsági elemzést és védelmet, digitális élményt, automatizálást és üzleti elemzést is biztosít, valamint a mesterséges intelligencia terén is együtt halad a piaci igényekkel, olvasható az elemzésben.

A Gartner a tavalyi Magic Quadrantjában a Datadogot, a New Relicet, a Grafana Labsot, a Splunkot, a Cronosphere-t és az Elasticot sorolta még a vezetők (leaders) negyedébe.

A piackutatók szinte egyöntetűen úgy érzékelik, hogy világ fejlett részei egyre nagyobb lelkesedéssel élnek a obszervabilitást biztosító eszközök és rendszerek kínálta lehetőségekkel. Noha a hagyományos monitorozó rendszerek sem tűnnek el a következő évtizedben, jelentőségük csökken a fejlettebb, proaktív megoldások terjedésével.

Ez a cikk független szerkesztőségi tartalom, mely a Dynatrace támogatásával készült. Részletek »

Szakmai nap a jövőálló digitális infrastruktúra jegyében

A digitális infrastruktúra új kihívásai - legyen szó MI megoldásokról, szigorodó fenntarthatósági követelményekről, vagy az reziliens és szünetmentes működésről - szinte minden nagyobb szervezet életében meghatározó szerepet játszanak. Egy szakmai rendezvénysorozat segítségével közelebb kerülhetünk a megoldásokhoz és segítséget kaphatunk az új technológiák sikeres implementálásához.

Nyílt forráskód: valóban ingyenes, de használatának szigorú szabályai vannak