Már majdnem pontosan két évvel ezelőtt is beszámoltunk olyan kutatásról, amely az önvezető autók jelfelismerő rendszereit célzó, meglehetősen egyszerű támadásokkal foglalkozott. Abban a New York állambeli Cornell Egyetem kutatói toxikus jeleknek nevezték azokat az autonóm járművek megtévesztésére alkalmas jelzéseket, amelyek az emberek szemében változatlannak látszanak, de néhány apró módosítással kiválóan alkalmasak az MI-rendszerek megtévesztésére. A kísérletek során akkor digitális és fizikai környezetekben is 90 százalékos hatékonysággal verték át a mesterséges intelligenciát, még olyankor is, amikor nem voltak vele tisztában, hogy éppen milyen algoritmust támadnak.

A szakemberek a gépi tanuló algoritmusok célzott felkészítését javasolták egy nagy csomó minta legyártásával és feldolgozásával. Ezzel saját kutatásaikban mindössze néhány százalékosra szorították le a toxikus jelek hatékonyságát a támadó szándékú táblák, a logó alapú támadások vagy az olyan egyedi jelzések esetében, amelyek üres felületekre maszkolnak megtévesztő ábrákat, vagy az emberi sofőr és a járműre épített kamera betekintési szögének különbözőségével operálnak. Azt már akkor elmondták, hogy a problémát így sem lehet megszüntetni, de a hatásai mérsékelhetők; a jelek szerint azonban az elmúlt időszakban nem mindenki vette komolyan a figyelmeztetést.

A gépek tévedni is következetesebben szoktak

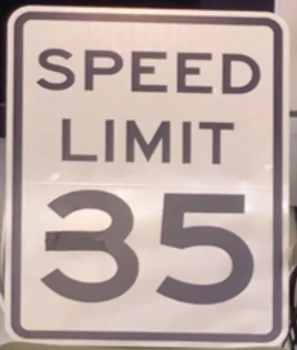

A McAfee Labs kutatói szerdán tették közzé azt a kutatást, amelyben ilyen-olyan módszerekkel torzítgatták vagy koszolták a táblákat, és közben azt vizsgálták, hogy a Tesla rendszere milyen eséllyel érti félre a jelzéseket. Ezek közül talán a leglátványosabb az az egyszerű hekkelés, amelyben egy darabka szigetelőszalagot ragasztanak a 35 mérföld/órás (körülbelül 56 kilométer/órás) jelzésre, hogy a kipróbált Model X és Model S típusok rendszere ezt érzékelve 85 mérföld/órára (136 kilométer/órára) próbálja meg felgyorsítani a járműveket. Mindehhez elég volt a ragasztócsíkkal meghosszabbítani a hármas középső vonalát:

forrás: mcafee.com

Az anyagból kiderül, hogy a fenti jelenség a MobilEye (Intel) EyeQ3 chipjeivel dolgozó kamerarendszereket érinti, amelyek a Tesla régebbi járműveiben találhatók, a gyártó terminológiájában a Hardware Pack 1 részeként, és szükség van hozzá a Traffic Aware Cruise Control (TACC) vezetéstámogató megoldásra is, ami automatikusan szabályozza a járművek sebességét a forgalmi viszonyoknak (így a jelzőtábláknak) megfelelően. A McAfee Labs szerint a teszteket számtalanszor megismételve arra a következtetésre jutottak, hogy a mozgásban lévő autók nem 100 százalékosan tévesztenek, utóbbi esetben viszont 100 százalék biztonsággal váltanak a helytelenül becélzott sebességhatárra.

Első lépésben tisztába kell jönni a problémával

A kutatók megállapítják, hogy a sofőr az esetek többségében minden bizonnyal érzékeli a problémát, és beavatkozik a fékre taposva vagy a TACC kikapcsolásával (az alábbi videón a 35 mérföldes korlátozásnál ez 50 mérföld per órás sebességnél sikerül neki), és ezzel jó eséllyel megelőzik a baleseteket. Azonban így is olyan problémákról van szó, amelyekkel a gyártóknak és a felhasználóknak is érdemes lenne tisztában lenniük, hogy lehetővé váljon a lényegesen biztonságosabb járművek fejlesztése. A MobilEye EyeQ3-as kamerarendszerei egyébként már 40 millió autóban működnek világszerte, és azzal együtt, hogy most csak a Teslákat próbálgatták, ilyenek dolgoznak a Cadillac, a Nissan, az Audi vagy a Volvo gyártmányaiban is.

A magas autonómiaszintű járművek betrükközése a mesterséges intelligencia fejlesztésében jelentkező kihívások egyik leglátványosabb területe, amire az utóbbi időben több példát is találhattunk. A Cornell Egyetem fent idézett kutatásában mások mellet egy KFC-logót buheráltak meg alig észrevehető módon, hogy a járműveket irányító rendszer stoptáblának nézze, de más tesztekkel is szemléltették, hogy mekkora gond lehet, ha az autó a legváratlanabb helyzetekben 130-ról 30 kilométer per órára fékezi magát egy kamu korlátozó tábla miatt. A Tencent kutatói egy másik alkalommal azt mutatták be, hogy az aszfaltra ragasztott matricákkal a sávtartásért felelős alrendszerek zavarhatók össze nagyon komolyan. A lényeg minden esetben az, hogy az intelligensnek reklámozott technológiák egyáltalán nem intelligensek, amennyiben egy egész kicsit is ki kellene lépniük a fejlett célgépek szerepéből.

Ugyanilyen zavarba ejtő, hogy a The Register kérdésére a McAfee szakemberei elmondták: a vizsgálatok eredményéről már majdnem fél éve, tavaly szeptemberben tájékoztatták a Tesla és a MobileEye illetékeseit. Formálisan mindkét helyen érdeklődést mutattak a felfedezések iránt, de sem akkor, sem azóta nem jelezték, hogy bármilyen tervük lenne a probléma kezelésére a már forgalomban lévő járműveken. A lap természetesen a Tesla álláspontjára is kíváncsi volt ezzel kapcsolatban, de a társaság a cikk megjelenéséig nem válaszolt a kérdéskre.

EGY NAPBA SŰRÍTÜNK MINDENT, AMIT MA EGY PROJEKTMENEDZSERNEK TUDNIA KELL!

Ütős esettanulmányok AI-ról, agilitásról, csapattopológiáról. Folyamatos programok három teremben és egy közösségi térben: exkluzív információk, előadások, interaktív workshopok, networking, tapasztalatcsere.

2026.03.10. UP Rendezvénytér

Nyílt forráskód: valóban ingyenes, de használatának szigorú szabályai vannak