Ez a Facebook válasza a Google nagylelkűségére. A keresőóriás egy hónapja jelentette be, hogy megnyitja a mesterséges intelligencia (AI – artificial intelligence) rendszerek fejlesztéséhez készített fejlesztői környezete, a TensorFlow forráskódját. Most viszont a Facebook hardverdizájnt mesterséges intelligenciához a fejlesztői közösségnek.

Tegnap jelentette be a cég, hogy az Open Compute Project keretében bárki által felhasználhatóvá teszi saját mesterséges intelligencia rendszereihez fejlesztett speciális szerverének a terveit.

A Facebook még 2011-ben hozta létre az Open Compute Project (OCP) nevű kezdeményezést. Az oregoni Prineville-ben található adatközpontjának kialakításakor nyilvánossá tette az adatközponti szerverek informatikai dokumentációját. Az OCP közösségének célja olyan adatközponti hardverek megalkotása, amelyekkel egyszerűbbé és olcsóbbá tehető a skálázható rendszerek (webes kiszolgálók, cloud computing stb.) üzemeltetése, nyílt és szabadon hozzáférhető vagy módosítható tervekkel könnyítve meg a kivitelezést. Az OCP-hez azóta egy sor cég csatlakozott szállítói oldalról (Cisco, HP, Intel, Microsoft, VMware stb.) és vevői (Goldman Sachs, Bank of America stb.) oldalról egyaránt.

Big Sur – mesterséges intelligenciához

A Facebook még tavaly indította célzott mesterséges intelligencia kutatásait. A Facebook AI Research három kutatócsapata – kettő az Egyesült Államokban, egy pedig idén nyártól Párizsban – főleg olyan területeket kutat, melyek a közösségi oldal szolgáltatásainak a bővítését, valamint a felhasználói profilok tökéletesítését szolgálják: természetes nyelvi feldolgozást, valamint kép- és beszédfelismerést. Ugyanakkor a csapatok azzal is foglalkoznak, hogy tökéletesítsék a mesterséges intelligencia alkalmazások futtatásához szükséges infrastruktúrát.

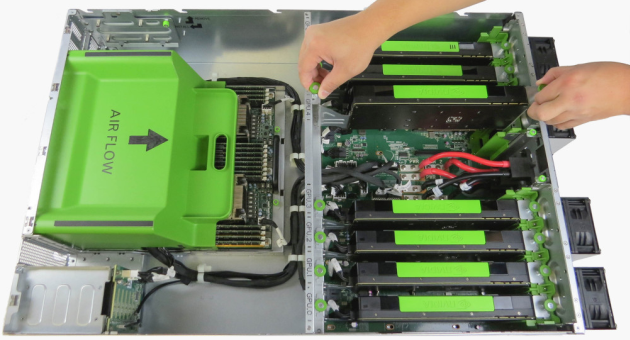

Ennek a munkának az eredménye a Big Sur névre keresztelt szerver. Az Open Rack-kompatibilis szerverek az Nvidia Tesla GPU-i köré épülnek. (Azt már korábban felfedezték, hogy a GPU-k nagyon jól teljesítenek nagy számítási igényű feladatoknál, emiatt például szuperszámítógépeknél is előszeretettel használják azokat.) Egy egységben nyolc darab Nvidia Tesla GPU M40 van. Ezeket a grafikus processzorokat szűk hónapja mutatta be a távol-keleti gyártó kifejezetten a gépi tanulást célzó hardverekhez.

Big Sur: nagy a teljesítménye, és gyerekjáték szerelni

A Big Surok kialakításában minden az adatközponti felhasználást segíti: egyszerűen karbantartható, bármelyik alkatrész – még az alaplap is – gyorsan és egyszerűen cserélhető. Gyakorlatilag csak a hűtőbordák felhelyezéséhez kell csavarhúzó, minden más kézzel megoldható.

AI-fejlesztők, szabad a vásár!

A Facebook részéről azonban egyáltalán nem jótékonyság, hogy eddigi eredményeit bárki számára elérhetővé teszi. Egyfelől ez reményeik szerint ösztönzőleg hat majd a tehetséges fejlesztőkre, hogy közvetve vagy közvetlenül beszálljanak a Facebooknál folyó fejlesztésekbe. Ugyanakkor az sem elhanyagolható előny, hogy ezzel a vállalat lényegében "ki tudja szervezni" kutató-fejlesztő tevékenységének egy szeletkéjét úgy, hogy annak költségei sem kell állnia. Ráadásul ezzel még az Amerikában is egyre nagyobb gondot okozó munkaerő-hiányra is gyógyír lehet.

Nem elhanyagolható a szabványosodás kérdése sem. A Facebook nem is tagadja, hogy számít a közösség erejére abban, hogy a Big Sur architektúrája szabvánnyá váljon. Ez ugyanis hosszabb távon a Facebook számára is olcsóbbá teszi a technológiát.

Produktivitás mint stratégiai előny: mit csinálnak másként a sikeres cégek?

A META-INF által szervezett Productivity Day 2026 idén a mesterséges intelligencia és a vállalati produktivitás kapcsolatát helyezi fókuszba. Az esemény középpontjában a META-INF nagyszabású produktivitási kutatásának bemutatása áll, amely átfogó képet nyújt a magyar vállalatok hatékonyságáról és működési kihívásairól.

EGY NAPBA SŰRÍTÜNK MINDENT, AMIT MA EGY PROJEKTMENEDZSERNEK TUDNIA KELL!

Ütős esettanulmányok AI-ról, agilitásról, csapattopológiáról. Folyamatos programok három teremben és egy közösségi térben: exkluzív információk, előadások, interaktív workshopok, networking, tapasztalatcsere.

2026.03.10. UP Rendezvénytér