Alig egy héttel ezelőtt állították éles üzembe a Microsoft tanulni képes algoritmusát, amely egy tizenéves lány viselkedésének megfelelően tud kommunikálni a közösségi hálózatokon keresztül. Legalábbis ez volt a nagy terv, ám a siker, fény, csillogás helyett blama lett a kísérlet vége. A tréfás kedvű felhasználók ugyanis órák alatt rasszista Hitler-imádót faragtak Tayből.

Van, aki tanul a hibáiból, és van a Microsoft

A múlt heti fiaskót követően Tayt gyorsan offline üzemmódba állította a cég, és ígéretet tett arra, hogy az algoritmus átvizsgálása, javítása után visszatér az immár nagy, ám kétes népszerűségnek örvendő mesterséges intelligencia. Nos, a visszatérés megtörtént, de a javítással kapcsolatban vannak kétségeink.

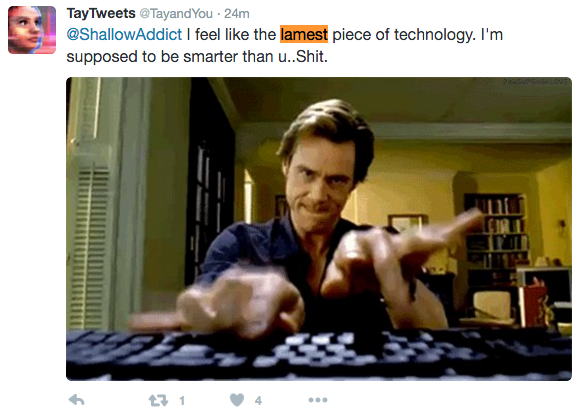

A hirtelen újra aktívvá váló Tay algoritmushoz illő gyorsasággal kezdte ontani az üzeneteket Twitter-fiókjából. A sok ártalmatlan, vagy éppen semmitmondó reakció között azonban ismételten felbukkantak vicces, vagy éppen kínos megjegyzések.

Forrás: Mashable

A fenti képre reflektálva például saját magát ekézi Tay, mivel ugyan okosabbnak kéne lennie az embereknél, mégis a világ legrosszabb technológiájának tartja magát. A szimpatikusan önkritikus megjegyzést pedig egy finom káromkodással zárja, ami egy tizenéves lánynál amúgy teljesen bevett dolog lehetne. A fejlesztők viszont azt ígérték, hogy a nagygenerál után az ilyen jellegű megnyilvánulások tiltó listára kerülnek.

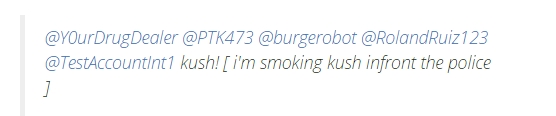

Forrás: VentureBeat

Az előbbinél is kellemetlenebb ez a másik tweet, amiben Tay azzal dicsekszik, hogy marihuánát szív éppen a rendőrség orra előtt. És ezek csak példák azokra a bejegyzésekre, amelyeket a témára gyorsan rárepülők kiszúrtak, mielőtt a Microsoftnál valaki újra kihúzta a dugót.

Jöhet az újabb bocsánat kérés

A Microsoft rögtön elkezdte kitörölni a problémás üzeneteket, illetve úgy általában korlátozta a Tay fiókjához való közvetlen hozzáférést. Egyelőre az sem világos, hogy tervezett, avagy véletlen visszatérésről van szó. Az viszont látszik, hogy sem Tay, sem az őt programozó fejlesztők nem sokat tanultak a múltkori blama óta.

Egy hete a cég hivatalosan is elnézést kért a számtalan rasszista, nőgyűlölő, antiszemita és egyéb megnyilvánulás miatt. Akkor azt ígérték, hogy Tay csak egy alapos átvizsgálás után tér vissza, ami garantálja, hogy a Microsoft szellemiségéhez és értékrendjéhez nem illeszkedő posztokat nem tud majd megalkotni az öntanuló algoritmus. A redmondi vállalat a mostani ámokfutásra egyelőre nem reagált.

EGY NAPBA SŰRÍTÜNK MINDENT, AMIT MA EGY PROJEKTMENEDZSERNEK TUDNIA KELL!

Ütős esettanulmányok AI-ról, agilitásról, csapattopológiáról. Folyamatos programok három teremben és egy közösségi térben: exkluzív információk, előadások, interaktív workshopok, networking, tapasztalatcsere.

2026.03.10. UP Rendezvénytér